超全的大模型面试题

扫描二维码下载资源

资源介绍

├── 21-RAG(Retrieval-Augmented Generation)评测面.pdf

├── 40-大模型(LLMs)训练集面.pdf

├── 26-大模型(LLMs)参数高效微调(PEFT) 面.pdf

├── 18-大模型(LLMs)RAG 版面分析——文本分块面.pdf

├── 27-适配器微调(Adapter-tuning)篇.pdf

├── 47-图解分布式训练(三) —— nn.parallel.DistributedDataParallel.pdf

├── 50-图解分布式训练(六)—— Pytorch的 DeepSpeed 详细解析.pdf

├── 34-基于lora的llama2二次预训练.pdf

├── 48-图解分布式训练(四) —— torch.multiprocessing 详细解析.pdf

├── 46-图解分布式训练(二) —— nn.DataParallel篇.pdf

├── 32-大模型(LLMs)增量预训练篇.pdf

├── 44-大模型(LLMs)分布式训练面.pdf

├── 9-大模型(LLMs)微调面.pdf

├── 28-提示学习(Prompting)篇.pdf

├── 4-Attention 升级面.pdf

├── 8-大模型(LLMs)进阶面.pdf

├── 6-LLMs 损失函数篇.pdf

├── 49-图解分布式训练(五) —— AMP混合精度训练 详细解析.pdf

├── 30-如何使用 PEFT库 中 LoRA?.pdf

├── 15-大模型 RAG 经验面.pdf

├── 7-相似度函数篇.pdf

├── 14-基于LLM+向量库的文档对话 经验面.pdf

├── 23-大模型(LLMs)RAG —— 关键痛点及对应解决方案.pdf

├── 33-增量预训练(Pretrain)样本拼接篇.pdf

├── 52-图解分布式训练(八)—— ZeRO 学习.pdf

├── 37-大模型(LLMs)强化学习——RLHF及其变种面.pdf

├── 3-LLMs 激活函数篇.pdf

├── 36-大模型(LLMs)强化学习面.pdf

├── 2-Layer normalization 篇.pdf

├── 24-大模型(LLMs)RAG 优化策略 —— RAG-Fusion篇.pdf

├── 42-大模型(LLMs)显存问题面.pdf

├── 20-大模型外挂知识库优化——负样本样本挖掘篇.pdf

├── 11-大模型(LLMs)langchain 面.pdf

├── 22-检索增强生成(RAG) 优化策略篇.pdf

├── 39-强化学习在自然语言处理下的应用篇.pdf

├── 17-大模型(LLMs)RAG 版面分析——表格识别方法篇.pdf

├── 10-LLMs 训练经验帖.pdf

├── 25-Graph RAG 面 — 一种 基于知识图谱的大模型检索增强实现策略.pdf

├── 51-图解分布式训练(七)—— accelerate 分布式训练 详细解析.pdf

├── 29-LoRA 系列篇.pdf

├── 19-大模型外挂知识库优化——如何利用大模型辅助召回?.pdf

├── 45-图解分布式训练(一) —— 流水线并行(Pipeline Parallelism).pdf

├── 38-大模型(LLMs)强化学习—— PPO 面.pdf

├── 1-大模型(LLMs)基础面.pdf

├── 12-多轮对话中让AI保持长期记忆的8种优化方式篇.pdf

├── 31-大模型(LLMs)推理面.pdf

├── 35-大模型(LLMs)评测面.pdf

├── 43-显存优化策略篇.pdf

├── 5-transformers 操作篇.pdf

├── 41-大模型(LLMs)LLM生成SFT数据方法面.pdf

├── 13-基于langchain RAG问答应用实战.pdf

├── 16-LLM文档对话 —— pdf解析关键问题.pdf

下载说明

方式一:扫码获取

- 微信扫描下面图片二维码进入【飞享助手】小程序

- 点击复制即可自动复制下载链接

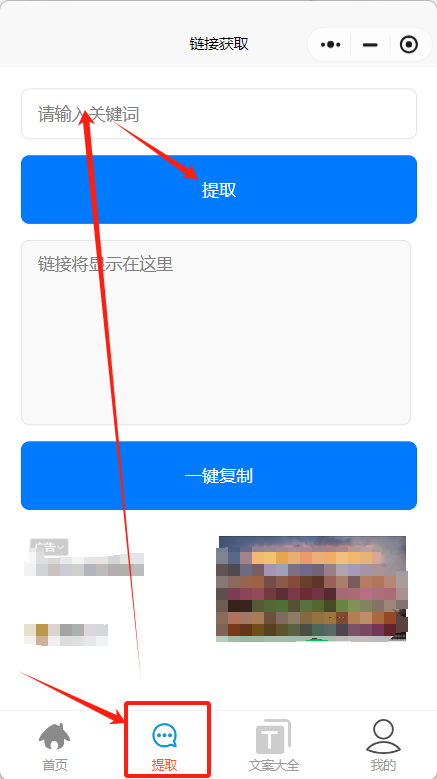

方式二:小程序获取

- 微信搜索小程序:飞享办公助手

- 点击导航栏:【提取】

- 输入关键词: VXZBLE

- 点击【提取】即可获取资源链接